你是否也遇到过以下情况?

- 提出一个完整问题,ChatGPT却只答一半,后文断裂。

- 明明刚说了“优势”,下一段却突然跳去“总结”,中间逻辑断档。

- 内容段落结构混乱,不按顺序展开,甚至“答非所问”。

如果你用的是 GPT-4 或 GPT-4o 模型,这种现象在 2025 年 6 月确实频繁发生。这类问题本质上属于“输出断裂”或“逻辑跳跃”型Bug,是目前ChatGPT用户反馈中最常见的稳定性问题之一。

本文将分析背后的模型机制、触发场景,并提供一整套实用应对策略,帮助你在使用 ChatGPT 时“让它讲完整、讲顺畅”。

🧠 一、问题表现类型汇总

| 表现类别 | 具体描述 |

|---|---|

| 内容断裂 | 输出中突然中止,缺少结尾或停在半句话 |

| 段落跳跃 | 直接从开头跳到总结,中间核心内容未交代 |

| 上下文错位 | 回复内容与之前问题对不上,答非所问 |

| 逻辑顺序错乱 | 本应“起—承—转—合”的结构,被写成“起—转—合—合” |

| 回答结构缺失 | 清单或分类内容输出不全,缺少要点或编号中断 |

🔍 二、2025年6月的成因分析:Bug?还是使用误区?

✅ 1. GPT-4o默认输出“对话优先”,非结构优先

GPT-4o(即“omni”模型)是当前 ChatGPT 默认模型。它响应速度快、语气自然,但对复杂逻辑任务的稳定性不如传统 GPT-4。

因此,当你要求它“写结构性内容”(如提纲、方案、列表)时,它可能会优先处理“语义连贯”,而忽视逻辑完整性。

✅ 2. 长指令或任务堆叠,超出处理窗口

当一个请求包含多层需求(如“请总结+分析+生成报告”),ChatGPT 有可能“记住了前半部分,漏掉后半部分”。

✅ 3. 上下文记忆被“覆盖污染”

在长对话中,如果前面的问题过于相似或含糊,模型可能自动关联错误上下文,导致回答跳段或断裂。

⚙️ 三、实用应对策略:防止跳逻辑、写不全的4大技巧

① 每个任务开新对话,避免上下文混乱

尤其是:写摘要、列清单、生成报告时,请单独开启新对话窗口,可最大限度减少“上下文污染”风险。

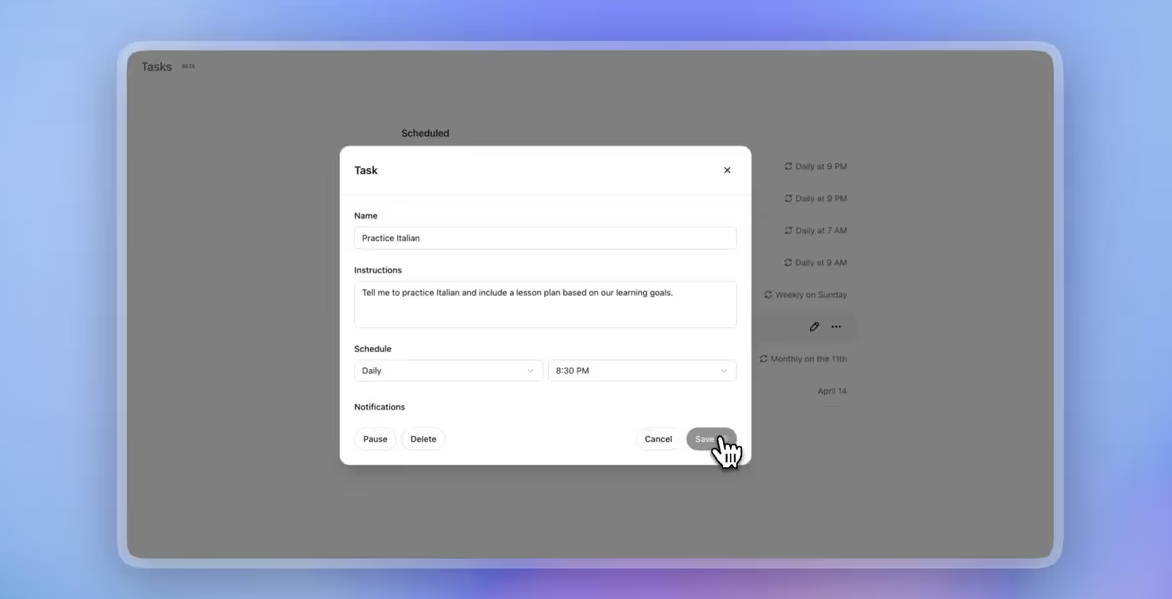

② 结构性输出时,用模板约束格式

明确告诉它你想要“哪几部分、按什么顺序”,而不是泛泛地说“写一篇”。

📝 示例提示词:

请按照“背景—问题—解决方案—预期效果”四部分结构,逐段写一份项目策划简案,每段100字左右,不要跳过任一部分。

③ 使用分步式提问法(Step-by-step)

不要在一句提示里塞太多任务。先让它完成“第一段”,再请求第二段,可有效避免“只写一半”或“结构断裂”。

🔁 示例流程:

- 第一步:请写出这篇文案的第一部分(背景介绍)

- 第二步:接着写“核心亮点”部分,保持风格一致

- 第三步:请补充最后一段“行动建议”

④ 开启 GPT-4 模型(非 GPT-4o)处理复杂任务

GPT-4 模型虽然速度稍慢,但更适合逻辑清晰、结构完整的输出任务。遇到“跳逻辑”问题频发时,建议手动切换模型。

切换路径:页面顶部模型栏 → 选择 GPT-4 → 开启对话。

🧩 四、补救策略:遇到断裂怎么办?

如果已经遇到回答“中断/跳跃”,你可以使用以下修复提示:

- “请继续上文的第X部分,不要重复前文内容”

- “请补充中间缺失的部分,保持原始风格和结构一致”

- “上文跳过了第二段,请补写”

这样可以让 ChatGPT 在原有上下文中,尽量找回丢失内容,而不是重新生成。

✅ 总结:断裂不是崩溃,跳段也能救回

2025年6月的 ChatGPT,仍处于模型优化与多模式集成阶段。你遇到的“断句”“跳段”“缺结尾”等问题,不一定是“系统崩了”,更多是使用方式与模型行为之间不匹配。

记住这几点,ChatGPT 就能更稳、更准、更像一个靠谱的内容助手:

- 用结构清晰的提示词

- 一步一步提问,不一次性“甩一堆”

- 开新对话、选对模型

- 用模板管好逻辑